Python 官方文档:入门教程 => 点击学习

在采集美女站时,需要对关键词进行分词,最终采用的是python的结巴分词方法。 中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。 其基本实现原理有三点: 1.基于Trie树结构实现高效的词

在采集美女站时,需要对关键词进行分词,最终采用的是python的结巴分词方法。

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。

其基本实现原理有三点:

1.基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG)

2.采用了动态规划查找最大概率路径, 找出基于词频的最大切分组合

3.对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法

安装(Linux环境)

下载工具包,解压后进入目录下,运行:Python setup.py install

模式

1.默认模式,试图将句子最精确地切开,适合文本分析

2.全模式,把句子中所有的可以成词的词语都扫描出来,适合搜索引擎

接口

• 组件只提供jieba.cut 方法用于分词

• cut方法接受两个输入参数:

• 第一个参数为需要分词的字符串

• cut_all参数用来控制分词模式

• 待分词的字符串可以是gbk字符串、utf-8字符串或者unicode

• jieba.cut返回的结构是一个可迭代的generator,可以使用for循环来获得分词后得到的每一个词语(unicode),也可以用list(jieba.cut(...))转化为list

• seg=jieba.cut("Http://www.gg4493.cn/"):

实例

#! -*- coding:utf-8 -*-

import jieba

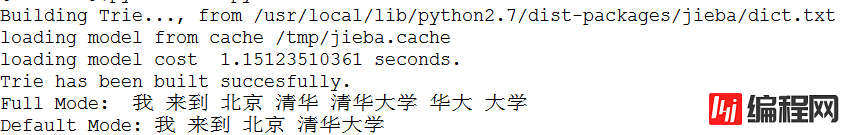

seg_list = jieba.cut("我来到北京清华大学", cut_all = True)

print "Full Mode:", ' '.join(seg_list)

seg_list = jieba.cut("我来到北京清华大学")

print "Default Mode:", ' '.join(seg_list)结果

以上这篇python中文分词,使用结巴分词对python进行分词(实例讲解)就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持编程网。

--结束END--

本文标题: python中文分词,使用结巴分词对python进行分词(实例讲解)

本文链接: https://www.lsjlt.com/news/16147.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0