目录项目特性安装colly实例colly 的配置colly页面爬取和解析colly框架重构爬虫golang爬虫框架 colly 简介 colly是一个采用Go语言编写的WEB爬虫框架

golang爬虫框架 colly 简介

colly是一个采用Go语言编写的WEB爬虫框架,旨在提供一个能够些任何爬虫/采集器/蜘蛛的简介模板,通过Colly。你可以轻松的从网站提取结构化数据,然后进行数据挖掘,处理或归档

go get -u GitHub.com/gocolly/colly第一个colly 应用

package main

import (

"fmt"

"github.com/gocolly/colly"

)

func main() {

c := colly.NewCollector()

// goquery selector class

c.Onhtml(".sidebar_link", func(e *colly.HTMLElement) {

e.Request.Visit(e.Attr("href"))

})

c.OnRequest(func(r *colly.Request) {

fmt.Println("url:",r.URL)

})

c.Visit("https://gORM.io/zh_CN/docs/")

}

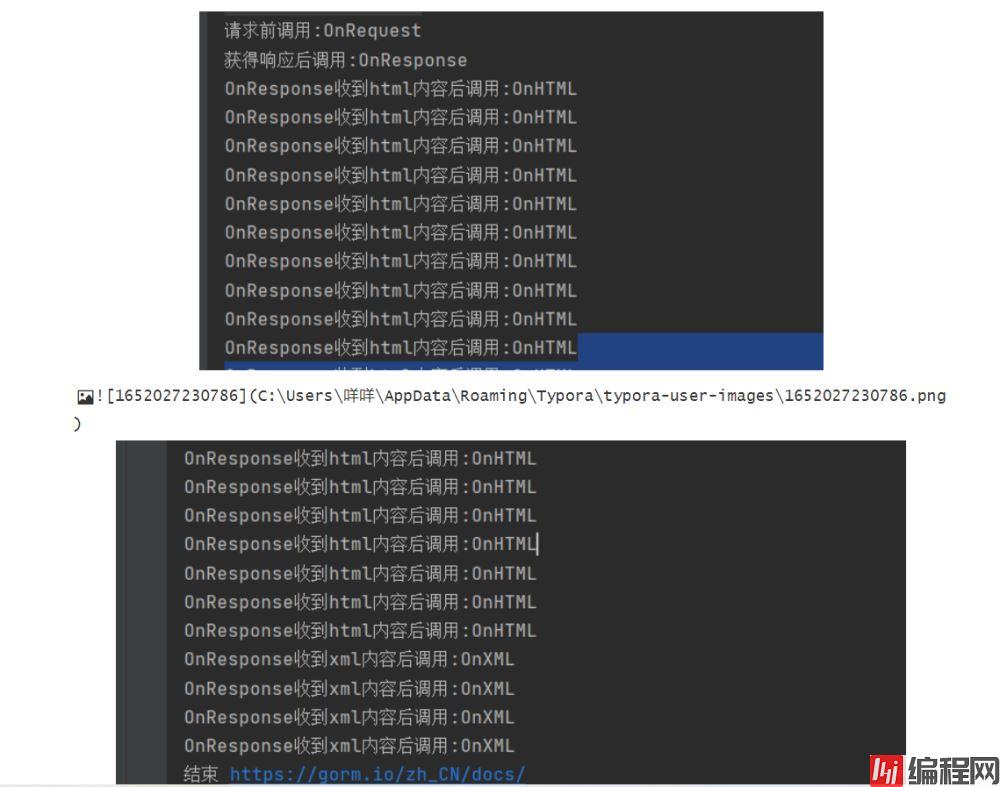

回调函数的调用顺序

func collback() { // 添加回调 收集器

c:= colly.NewCollector()

c.OnRequest(func(r *colly.Request) {

fmt.Println("请求前调用:OnRequest")

// fmt.Println("Visiting", r.URL)

})

c.OnError(func(_ *colly.Response, err error) {

fmt.Println("发生错误调用:OnReOnError")

//log.Println("Something went wrong:", err)

})

c.OnResponse(func(r *colly.Response) {

fmt.Println("获得响应后调用:OnResponse")

//fmt.Println("Visited", r.Request.URL)

})

c.OnHTML("a[href]", func(e *colly.HTMLElement) {

fmt.Println("OnResponse收到html内容后调用:OnHTML")

//e.Request.Visit(e.Attr("href"))

})

c.OnXML("//h1", func(e *colly.XMLElement) {

fmt.Println("OnResponse收到xml内容后调用:OnXML")

//fmt.Println(e.Text)

})

c.OnScraped(func(r *colly.Response) {

fmt.Println("结束", r.Request.URL)

})

c.Visit("Https://gorm.io/zh_CN/docs/")

}

得到的:

设置UserAgent

//设置UserAgent的两种方式:

设置Cookie

//设置cookie的两种方式

//方式一:通过手动网页添加cookies

c.OnRequest(func(r *colly.Request) {

r.Headers.Add("cookie","_ga=GA1.2.1611472128.1650815524; _gid=GA1.2.2080811677.1652022429; __atuvc=2|17,0|18,5|19")

})

// 方式二 :通过url 添加cookies

siteCookie := c.Cookies("url")

c.SetCookies("",siteCookie)

HTTP配置

Colly使用Golang的默认http客户端作为网络层。可以通过更改默认的HTTP roundtripper来调整HTTP选项。

c := colly.NewCollector()

c.WithTransport(&http.Transport{

Proxy: http.ProxyFromEnvironment,

DialContext: (&net.Dialer{

Timeout: 30 * time.Second,

KeepAlive: 30 * time.Second,

DualStack: true,

}).DialContext,

MaxIdleConns: 100,

IdleConnTimeout: 90 * time.Second,

TLSHandshakeTimeout: 10 * time.Second,

ExpectContinueTimeout: 1 * time.Second,

}

页面爬取和解析重点方法是 onHTML 回调方法

c.OnHTML("a[href]", func(e *colly.HTMLElement) {

fmt.Printf("e.Name:%v\n",e.Name)

e.Request.Visit(e.Attr("href"))

})

func html() {

c:= colly.NewCollector()

c.OnHTML("#sidebar", func(e *colly.HTMLElement) {

//fmt.Printf("e.Name:%v\n",e.Name) //名字

//fmt.Printf("e.Text:%v\n",e.Text) //文本

ret, _ := e.DOM.Html() // selector 选择器

fmt.Printf("ret:%v\n",ret)

})

c.OnRequest(func(r *colly.Request) {

fmt.Println("url:",r.URL)

})

c.Visit("https://gorm.io/zh_CN/docs/")

}

第一个参数是:goquery选择器,可以元素名称,ID或者Class选择器,第二个参数是根据第一个选择器获得的HTML元素结构如下:

package main

import (

"fmt"

"github.com/gocolly/colly"

)

func main() {

c:= colly.NewCollector()

c.OnHTML(".sidebar_link", func(e *colly.HTMLElement) { // 左侧链接

href := e.Attr("href")

if href != "index.html"{

c.Visit(e.Request.AbsoluteURL(href))

}

})

c.OnHTML(".article-title", func(h *colly.HTMLElement) { // 选择链接之后的标题

title := h.Text

fmt.Printf("title: %v\n",title)

})

c.OnHTML(".article", func(h *colly.HTMLElement) { //内容

content, _ := h.DOM.Html()

fmt.Printf("content: %v\n",content)

})

c.OnRequest(func(r *colly.Request) {

fmt.Println("url:",r.URL.String())

})

c.Visit("https://gorm.io/zh_CN/docs/")

}

到此这篇关于Golang爬虫框架 colly的使用的文章就介绍到这了,更多相关Golang colly内容请搜索编程网以前的文章或继续浏览下面的相关文章希望大家以后多多支持编程网!

--结束END--

本文标题: Golang爬虫框架colly的使用

本文链接: https://www.lsjlt.com/news/154048.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-04-05

2024-04-05

2024-04-05

2024-04-04

2024-04-05

2024-04-05

2024-04-05

2024-04-05

2024-04-04

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0