Python 官方文档:入门教程 => 点击学习

这篇文章主要介绍了怎么利用python多线程爬取天气网站图片并保存,具有一定借鉴价值,感兴趣的朋友可以参考下,希望大家阅读完这篇文章之后大有收获,下面让小编带着大家一起了解一下。1.1 题目指定一个网站,爬取这个网站中的所有的所有图片,例如

这篇文章主要介绍了怎么利用python多线程爬取天气网站图片并保存,具有一定借鉴价值,感兴趣的朋友可以参考下,希望大家阅读完这篇文章之后大有收获,下面让小编带着大家一起了解一下。

指定一个网站,爬取这个网站中的所有的所有图片,例如中国气象网(www.weather.com.cn),分别使用单线程和多线程的方式爬取。(限定爬取图片数量为学号后3位)

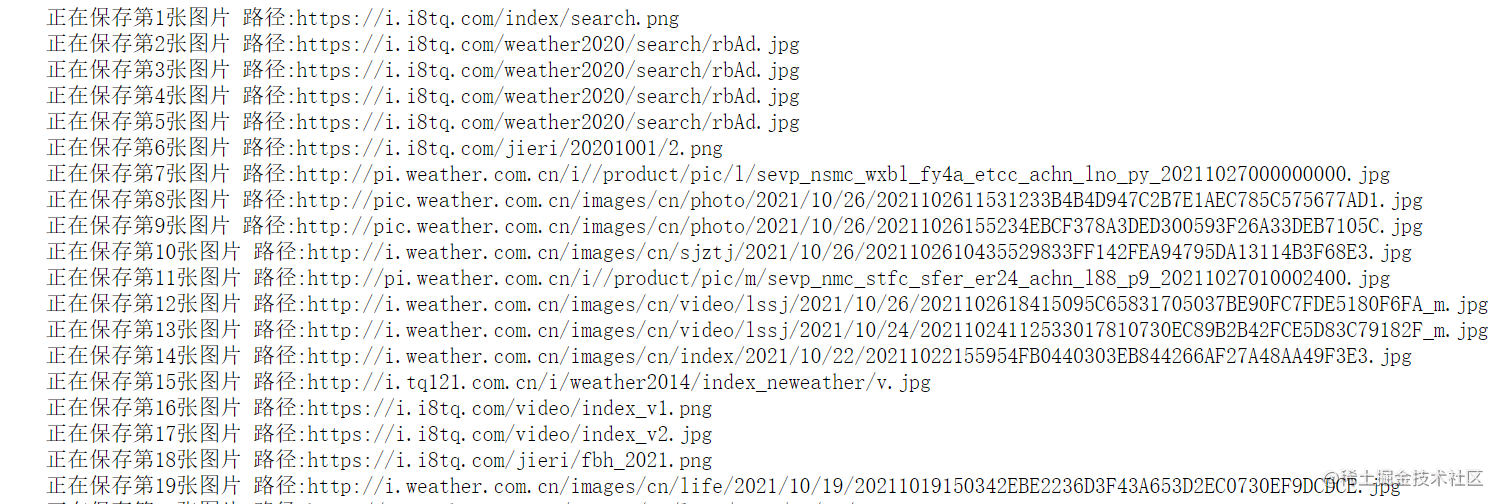

输出信息: 将下载的Url信息在控制台输出,并将下载的图片存储在images子文件中,并给出截图。

构造请求头

import requests,reimport urllibheaders = { 'Connection': 'keep-alive', 'Cache-Control': 'max-age=0', 'Upgrade-Insecure-Requests': '1', 'User-Agent': 'Mozilla/5.0 (windows NT 10.0; Win64; x64) AppleWEBKit/537.36 (Khtml, like Gecko) Chrome/94.0.4606.61 Safari/537.36', 'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9', 'Accept-Language': 'zh-CN,zh;q=0.9',}url = "Http://www.weather.com.cn/"request = urllib.request.Request(url, headers=headers)发送请求

request = urllib.request.Request(url, headers=headers)r = urllib.request.urlopen(request)页面解析,并且替换回车,方便后续进行正则匹配图片。

html = r.read().decode().replace('\n','')

使用正则匹配,先获取所有的a标签,然后爬取a标签下面的所有图片

urlList = re.findall('<a href="(.*?)" ',html,re.S)获取所有的图片

allImageList = []for k in urlList: try: request = urllib.request.Request(k, headers=headers) r = urllib.request.urlopen(request) html = r.read().decode().replace('\n','') imgList = re.findall(r'<img.*?src="(.*?)"', html, re.S) allImageList+=imgList except Exception as e: pass这里的请求其实也是要用多线程爬取的,所有后续会补上!

for i, img in enumerate(allImageList[:102]): print(f"正在保存第{i + 1}张图片 路径:{img}") resp = requests.get(img) with open(f'./image/{img.split("/")[-1]}', 'wb') as f: # 保存到这个image路径下 f.write(resp.content)

引入多进程模块

import threading# 多线程def download_imgs(imgList,limit): threads = [] T = [ threading.Thread(target = download, args=(url,i)) for i, url in enumerate(imgList[:limit + 1]) ] for t in T: t.start() threads.append(t) return threads编写下载函数

def download(img_url,name): resp = requests.get(img_url) try: resp = requests.get(img_url) with open(f'./images/{name}.jpg', 'wb') as f: f.write(resp.content) except Exception as e: print(f"下载失败: {name} {img_url} -> {e}") else: print(f"下载完成: {name} {img_url}")就很随机

感谢你能够认真阅读完这篇文章,希望小编分享的“怎么利用Python多线程爬取天气网站图片并保存”这篇文章对大家有帮助,同时也希望大家多多支持编程网,关注编程网Python频道,更多相关知识等着你来学习!

--结束END--

本文标题: 怎么利用python多线程爬取天气网站图片并保存

本文链接: https://www.lsjlt.com/news/305190.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0