这篇文章将为大家详细讲解有关linux下CUDA如何安装和使用,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。CUDA是显卡厂商NVIDIA推出的运算平台。 CUD是一种由NVIDIA推出的通用并行计算架构

这篇文章将为大家详细讲解有关linux下CUDA如何安装和使用,小编觉得挺实用的,因此分享给大家做个参考,希望大家阅读完这篇文章后可以有所收获。

CUDA是显卡厂商NVIDIA推出的运算平台。 CUD是一种由NVIDIA推出的通用并行计算架构,该架构使GPU能够解决复杂的计算问题。

一般而言,在 Linux 下安装和使用 CUDA 的流程如下:

本文后半部分将根据以上流程介绍 CUDA 安装和使用的详细步骤。

首先检查系统是否有支持 CUDA 编程的 GPU。可使用

lspci | grep -i nvidia命令来查看当前系统的 GPU 型号。

本人使用的操作系统由 Google Cloud Compute Engine 生成的包含 GPU 的虚拟机实例提供,系统版本为 ubuntu 16.04 LTS,GPU 为 NVIDIA Tesla K80 (1个)。上述命令输出

00:04.0 3D controller: NVIDIA Corporation GK210GL [Tesla K80] (rev a1)注意:与通常在本地主机上运行的虚拟机不同,这里的虚拟机直接运行在 Google 的云服务器上,可以为其申请 GPU 配额并安装 NVIDIA Driver 和 CUDA Toolkit.

传统上,安装 NVIDIA Driver 和 CUDA Toolkit 的步骤是分开的,但实际上我们可以直接安装 CUDA Toolkit,系统将自动安装与其版本匹配的 NVIDIA Driver。下面我们讲述安装 CUDA Toolkit 的方法。

在安装 CUDA Toolkit 前,要确保系统安装了 GCc 和 make。如果希望使用 c++ 进行 CUDA 编程,需要安装 g++。如果想要运行 CUDA 例程序,需要安装相应的依赖库。

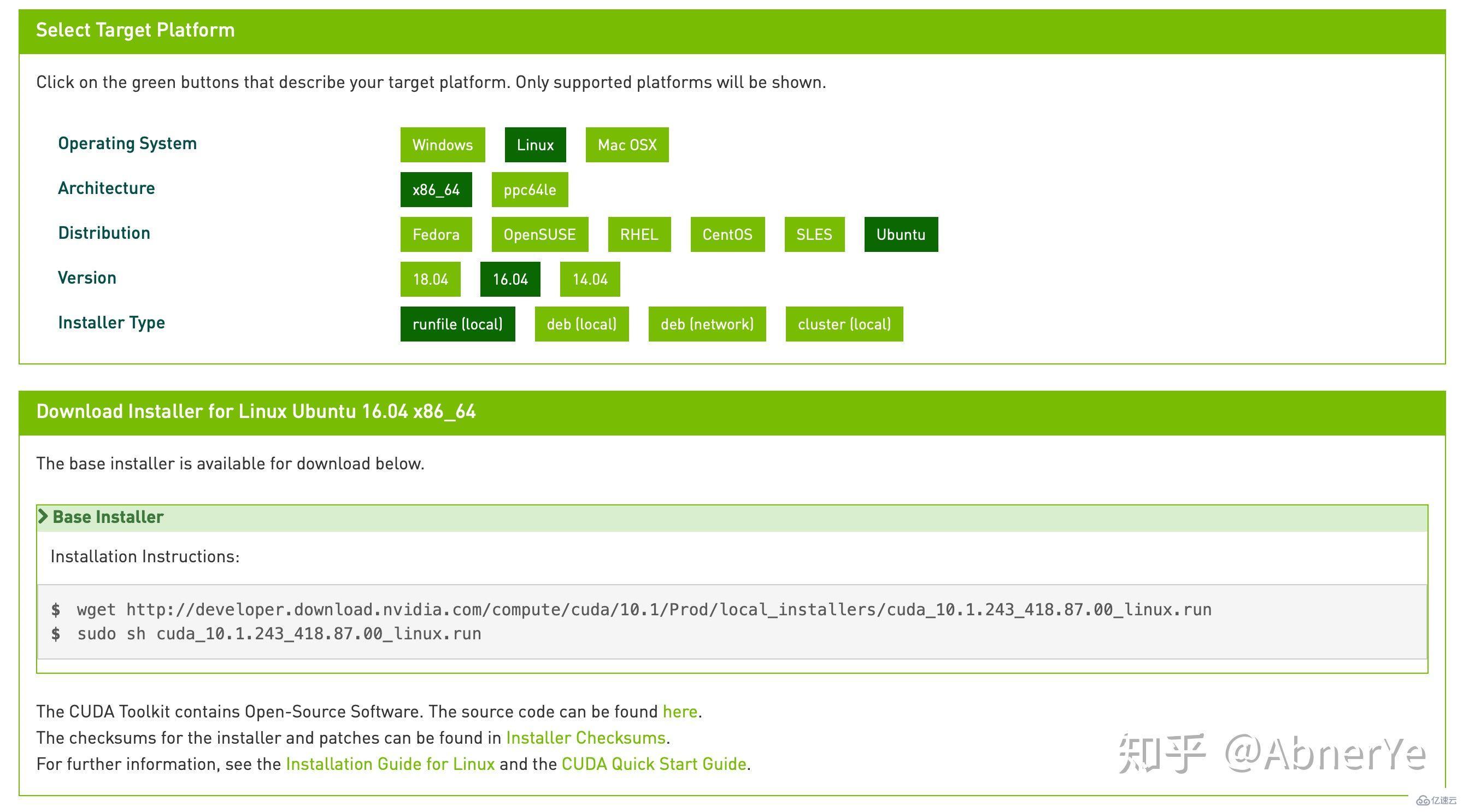

sudo apt update # 更新 apt sudo apt install gcc g++ make # 安装 gcc g++ make sudo apt install libglu1-mesa libxi-dev libxmu-dev libglu1-mesa-dev freeglut3-dev # 安装依赖库在 CUDA Toolkit 的下载页面选择系统版本和安装方式,下载并运行 runfile。

CUDA Toolkit 下载页面

CUDA Toolkit 下载页面

下载 CUDA Toolkit (文件较大):

wget Http://developer.download.nvidia.com/compute/cuda/10.1/Prod/local_installers/cuda_10.1.243_418.87.00_linux.run安装 CUDA Toolkit (时间较长):

sudo sh cuda_10.1.243_418.87.00_linux.run安装好 CUDA Toolkit 后,屏幕上将输出:

Driver: Installed Toolkit: Installed in /usr/local/cuda-10.1/ Samples: Installed in /home/abneryepku/ Please make sure that - PATH includes /usr/local/cuda-10.1/ - LD_LIBRARY_PATH includes /usr/local/cuda-10.1/lib64, or, add /usr/local/cuda-10.1/lib64 to /etc/ld.so.conf and run ldconfig as root这表示 NVIDIA Driver 和 CUDA Toolkit 已安装完毕。后半段安装信息提示我们修改环境变量 PATH 和 LD_LIBRARY_PATH. 在 ~/.bashrc 文件中写入

# add nvcc compiler to path export PATH=$PATH:/usr/local/cuda-10.1/bin # add cuBLAS, cuSPARSE, cuRAND, cuSOLVER, cuFFT to path export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-10.1/lib64:/usr/lib/x86_64-linux-gnu即可完成 CUDA 的配置。

注意事项:

环境变量 PATH 设置可执行程序的搜索路径,LD_LIBRARY_PATH 设置动态链接库的搜索路径

\2. CUDA, cuRAND 等动态库均位于 /usr/local/cuda-10.1/lib64 路径中。在 CUDA 10.0 以前,cuBLAS 也位于此路径下,但在 CUDA 10.1 中,cuBLAS 被迁移到了 /usr/lib/x86_64-linux-gnu 中。可以通过运行

sudo find / -iname libcublas*来寻找 cuBLAS 动态库的路径。

\3. 使用 Anaconda 安装的 CUDA Toolkit 不位于 lib64 路径中,也不会产生冲突。

可以在路径

/usr/local/cuda-10.1/extras/demo_suite路径下找到一些样例程序。deviceQuery 将输出 CUDA 的相关信息:

CUDA Device Query (Runtime api) version (CUdart static linking) Detected 1 CUDA Capable device(s) Device 0: "Tesla K80" CUDA Driver Version / Runtime Version 10.1 / 10.1 CUDA Capability Major/Minor version number: 3.7 Total amount of global memory: 11441 MBytes (11996954624 bytes) (13) Multiprocessors, (192) CUDA Cores/MP: 2496 CUDA Cores GPU Max Clock rate: 824 MHz (0.82 GHz) Memory Clock rate: 2505 Mhz Memory Bus Width: 384-bit L2 Cache Size: 1572864 bytes Maximum Texture Dimension Size (x,y,z) 1D=(65536), 2D=(65536, 65536), 3D=(4096, 4096, 4096) Maximum Layered 1D Texture Size, (num) layers 1D=(16384), 2048 layers Maximum Layered 2D Texture Size, (num) layers 2D=(16384, 16384), 2048 layers Total amount of constant memory: 65536 bytes Total amount of shared memory per block: 49152 bytes Total number of reGISters available per block: 65536 Warp size: 32 Maximum number of threads per multiprocessor: 2048 Maximum number of threads per block: 1024 Max dimension size of a thread block (x,y,z): (1024, 1024, 64) Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535) Maximum memory pitch: 2147483647 bytes Texture alignment: 512 bytes Concurrent copy and kernel execution: Yes with 2 copy engine(s) Run time limit on kernels: No Integrated GPU sharing Host Memory: No Support host page-locked memory mapping: Yes Alignment requirement for Surfaces: Yes Device has ECC support: Enabled Device supports Unified Addressing (UVA): Yes Device supports Compute Preemption: No Supports Cooperative Kernel Launch: No Supports MultiDevice Co-op Kernel Launch: No Device PCI Domain ID / Bus ID / location ID: 0 / 0 / 4 Compute Mode: deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 10.1, CUDA Runtime Version = 10.1, NumDevs = 1, Device0 = Tesla K80 Result = PASSCUDA 的各种特性:纹理内存 (texture memory)、常量内存 (constant memory)、共享内存 (shared memory)、块 (block)、线程 (thread)、统一寻址 (unified addressing) 都包含在以上信息中。了解这些特性是进行 CUDA C/C++ 编程的基础。

其它程序如 bandwidthTest, vectorAdd 等也将对 CUDA 的性能进行测试。

nvcc 是 CUDA C/C++ 的编译器,可以直接编译包含 C++ 语法的 (.cu) 源文件,语法和 gcc 类似。nvcc 的路径位于:

/usr/local/cuda-10.1/bin在命令行中输入

nvcc --version可查看 CUDA C/C++ 编译器 nvcc 的版本,本机结果如下

nvcc: NVIDIA (R) Cuda compiler driver Copyright (c) 2005-2019 NVIDIA Corporation Built on Sun_Jul_28_19:07:16_PDT_2019 Cuda compilation tools, release 10.1, V10.1.243使用 nvcc 编译包含了 CUDA Library 的源文件时,需要在 nvcc 命令中添加相应的 flag。例如,cuRAND 的 flag 为 -lcurand,cuBLAS 的 flag 为 -lcublas。如果不希望每次编译时都加上这些动态库的话,可以在 .bashrc 中写入

alias nvc="nvcc -std=c++11 -lcurand -lcublas”然后使用 nvc 来进行 C/C++ 文件的编译。

为了体验 GPU 编程,测试一个简单的 CUDA C++ 程序:两个整型向量的加法

#include #include using namespace std; __global__ void add(int *a, const int *b){ int i = blockIdx.x; a[i] += b[i]; } int main(){ const int N = 10; // number of elements int *a, *b, *temp, i; // malloc HOST memory for temp temp = new int [N]; // malloc DEVICE memory for a, b cudaMalloc(&a, N*sizeof(int)); cudaMalloc(&b, N*sizeof(int)); // set a's values: a[i] = i for(i=0;i>>(a, b); // show a's values cudaMemcpy(temp, a, N*sizeof(int), cudaMemcpyDeviceToHost); for(i=0;i上述代码使用的 CUDA 函数包括:cudaMalloc: 为指针申请 GPU 中的内存cudaMemcpy: CPU 和 GPU 之间的内存拷贝cudaFree: 释放指针指向的 GPU 内存将上述代码保存为文件 test.cu,并在命令行里输入 nvcc -std=c++11 -o test test.cu即可生成名为 test 的可执行文件。打开这个文件,屏幕上将输出 0 3 6 9 12 15 18 21 24 27注意:上述代码仅为测试 CUDA C/C++ 程序之用,不具有运行效率上的参考性。使用 Numba 进行 CUDA Python 编程Numba 是用于高性能计算的 Python 扩展库,它利用即时编译机制 (JIT) 将 Python 和 NumPy 的一部分代码转换为机器指令,从而大幅提高程序的运行速度。推荐使用 Anaconda 管理包括 Numba 在内的各种 Python 扩展库,因为它比 pip 方便许多。下载安装 Anaconda: wget https://repo.continuum.io/arcHive/Anaconda3-2019.07-Linux-x86_64.sh sudo sh Anaconda3-2019.07-Linux-x86_64.sh用 Anaconda 安装 CUDA Toolkit: conda install -c anaconda cudatoolkit使用 conda 安装的 CUDA Toolkit 位于 Anaconda 中,并且只能用于 Python。C/C++ 和 Anaconda 使用的 CUDA Toolkit 相互独立,可以同时存在且互不影响。使用 Anaconda 安装的 CUDA Toolkit 的版本不能超过 NVIDIA Driver 支持的最新的 CUDA 版本。Numba 是 Anaconda 自带的扩展库之一。在命令行中输入 numba -s可以查看硬件信息、操作系统信息、Python 版本、CUDA 版本信息。本机输出结果为:硬件信息: __Hardware InfORMation__ Machine : x86_64 CPU Name : broadwell Number of accessible CPU cores : 4 Listed accessible CPUs cores : 0-3 CFS restrictions : None CPU Features : 64bit adx aes avx avx2 bmi bmi2 cmov cx16 f16c fma fsgsbase invpcid lzcnt mmx movbe pclmul popcnt prfchw rdrnd rdseed rtm sahf sse sse2 sse3 sse4.1 sse4.2 ssse3 xsave xsaveopt操作系统信息: __OS Information__ Platform : Linux-4.15.0-1040-gcp-x86_64-with-debian-stretch-sid Release : 4.15.0-1040-gcp System Name : Linux Version : #42~16.04.1-Ubuntu SMP Wed Aug 7 16:42:41 UTC 2019 OS specific info : debianstretch/sid glibc infoPython 版本 __Python Information__ Python Compiler : GCC 7.3.0 Python Implementation : CPython Python Version : 3.7.3 Python Locale : en_US UTF-8CUDA 版本 __CUDA Information__ Found 1 CUDA devices id 0 b'Tesla K80' [SUPPORTED] compute capability: 3.7 pci device id: 4 pci bus id: 0 Summary: 1/1 devices are supported CUDA driver version : 10010 CUDA libraries: Finding cublas from Conda environment named libcublas.so.10.2.0.168 trying to open library... ok Finding cusparse from Conda environment named libcusparse.so.10.1.168 trying to open library... ok Finding cufft from Conda environment named libcufft.so.10.1.168 trying to open library... ok Finding curand from Conda environment named libcurand.so.10.1.168 trying to open library... ok Finding nvvm from Conda environment named libnvvm.so.3.3.0 trying to open library... ok Finding libdevice from Conda environment searching for compute_20... ok searching for compute_30... ok searching for compute_35... ok searching for compute_50... okNumba 的具体使用请参考官方文档。使用 Tensorflow + CUDA 进行 GPU 加速的 Python 编程使用 conda 安装 GPU 版本的 TensorFlow: conda install -c anaconda tensorflow-gpu在安装过程中可能会提示环境写入权限的错误: EnvironmentNotWritableError: The current user does not have write permissions to the target environment. environment location: /home/abneryepku/anaconda3 uid: 1001 gid: 1002可以使用修改文件夹权限的方法解决: sudo chown -R 1001:1002 /home/abneryepku/anaconda3安装好 TensorFlow 后,为了查看 GPU 是否可用,进入 Python 解释器环境,输入: import tensorflow as tf tf.test.is_gpu_available()即可查看 GPU 在 TensorFlow 中是否可用。其它扩展库如 PyTorch 可使用类似方法进行安装。关于“Linux下CUDA如何安装和使用”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,使各位可以学到更多知识,如果觉得文章不错,请把它分享出去让更多的人看到。

--结束END--

本文标题: Linux下CUDA如何安装和使用

本文链接: https://www.lsjlt.com/news/318563.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

一口价域名售卖能注册吗?域名是网站的标识,简短且易于记忆,为在线用户提供了访问我们网站的简单路径。一口价是在域名交易中一种常见的模式,而这种通常是针对已经被注册的域名转售给其他人的一种方式。

一口价域名买卖的过程通常包括以下几个步骤:

1.寻找:买家需要在域名售卖平台上找到心仪的一口价域名。平台通常会为每个可售的域名提供详细的描述,包括价格、年龄、流

443px" 443px) https://www.west.cn/docs/wp-content/uploads/2024/04/SEO图片294.jpg https://www.west.cn/docs/wp-content/uploads/2024/04/SEO图片294-768x413.jpg 域名售卖 域名一口价售卖 游戏音频 赋值/切片 框架优势 评估指南 项目规模

0