Python 官方文档:入门教程 => 点击学习

小编给大家分享一下python Requests爬虫中如何求取关键词页面,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!需求:爬取搜狗首页的页面数据imp

小编给大家分享一下python Requests爬虫中如何求取关键词页面,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!

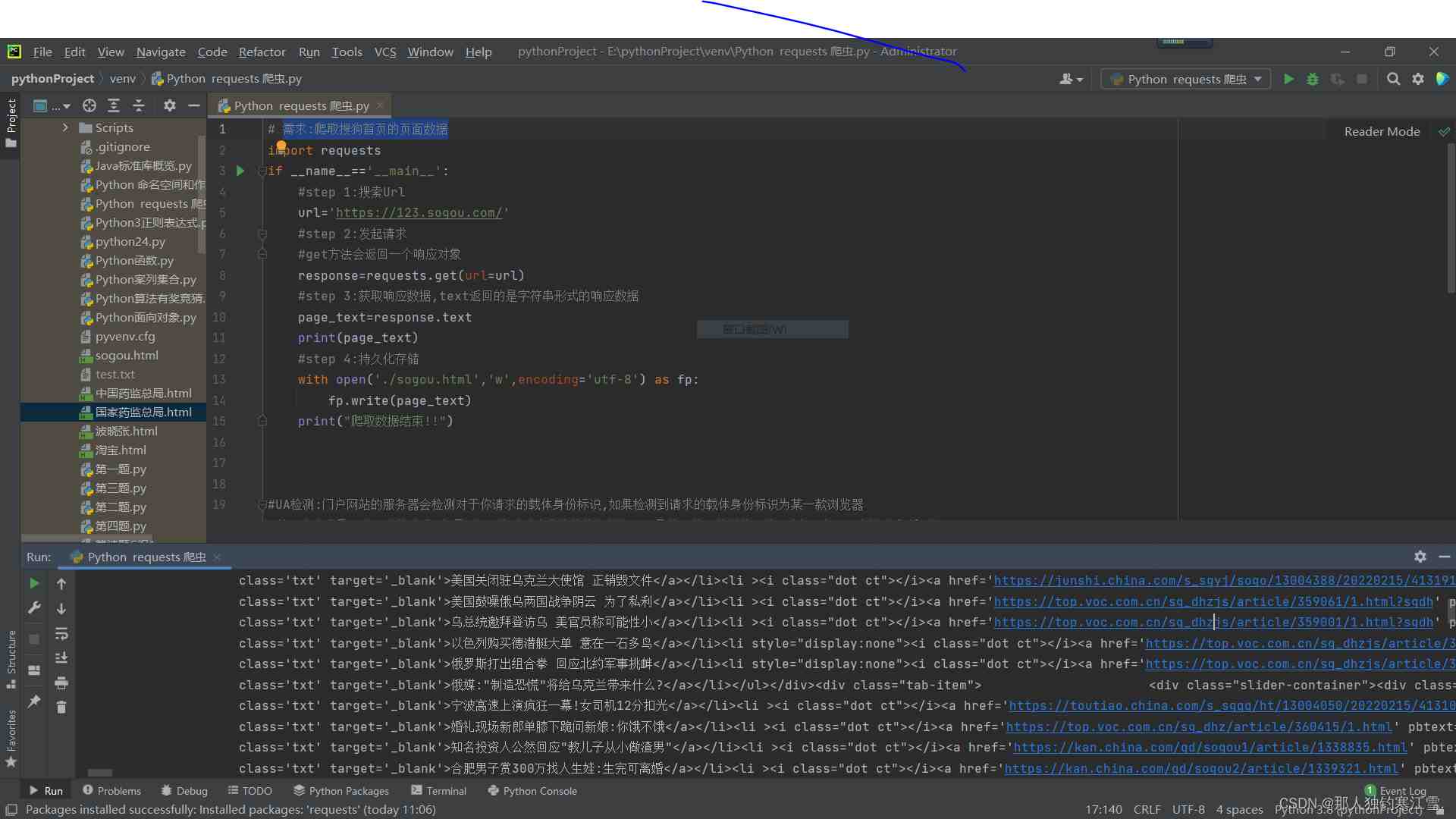

import requestsif __name__=='__main__': #step 1:搜索Url url='https://123.soGou.com/' #step 2:发起请求 #get方法会返回一个响应对象 response=requests.get(url=url) #step 3:获取响应数据,text返回的是字符串形式的响应数据 page_text=response.text print(page_text) #step 4:持久化存储 with open('./sogou.html','w',encoding='utf-8') as fp: fp.write(page_text) print("爬取数据结束")import requestsif __name__=='__main__': #step 1:搜索Url url='Https://123.sogou.com/' #step 2:发起请求 #get方法会返回一个响应对象 response=requests.get(url=url) #step 3:获取响应数据,text返回的是字符串形式的响应数据 page_text=response.text print(page_text) #step 4:持久化存储 with open('./sogou.html','w',encoding='utf-8') as fp: fp.write(page_text) print("爬取数据结束")

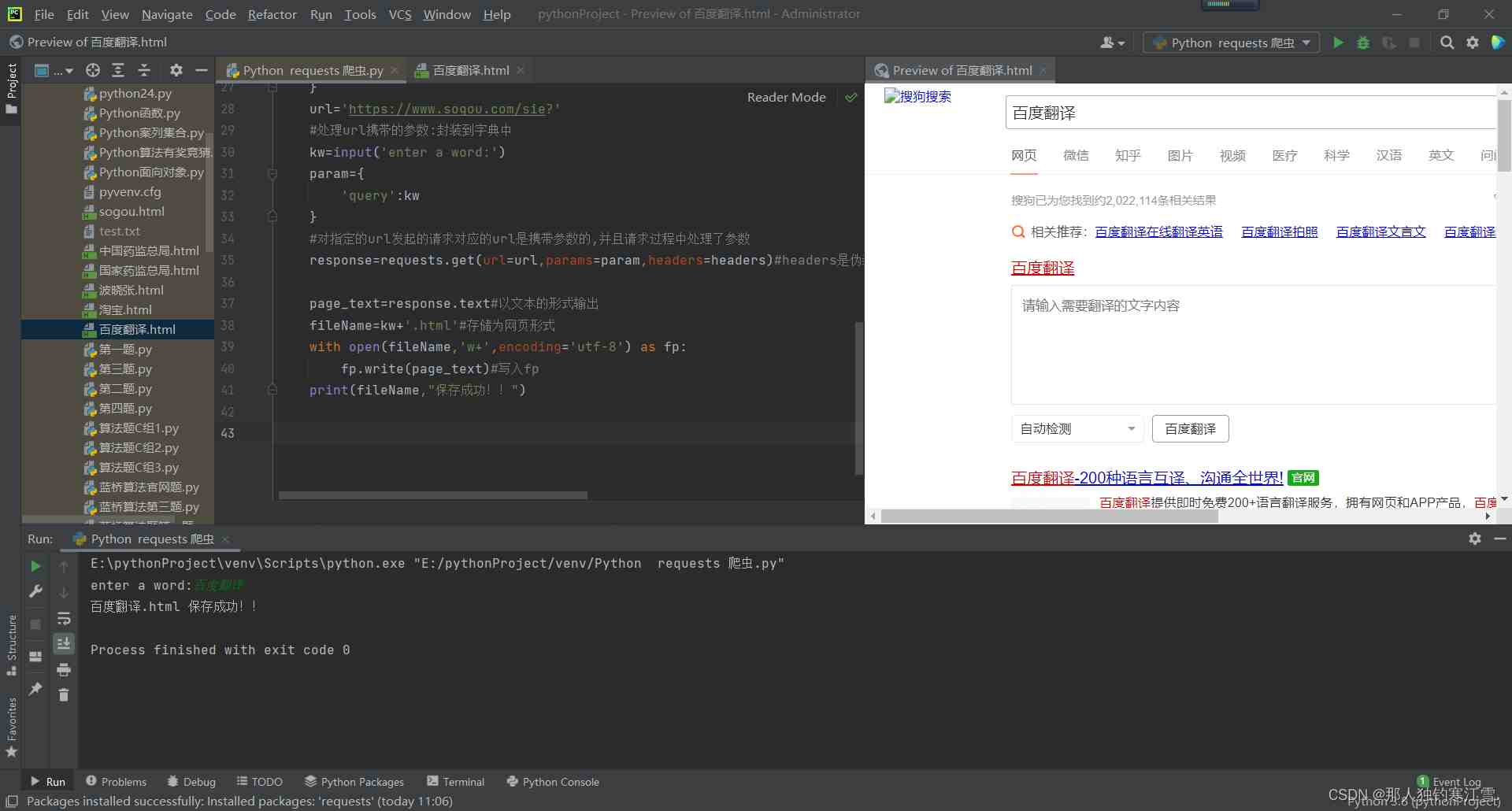

import requestsif __name__=='__main__': #UA伪装:将对应的User-Agent封装到一个字典中 headers={ 'User-Agent':'Mozilla/5.0 (windows NT 10.0; WOW64) AppleWEBKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.9 Safari/537.36' } url='https://www.sogou.com/sie?' #处理url携带的参数:封装到字典中 kw=input('enter a Word:') param={ 'query':kw } #对指定的url发起的请求对应的url是携带参数的,并且请求过程中处理了参数 response=requests.get(url=url,params=param,headers=headers)#headers是伪装 params输入关键词 page_text=response.text#以文本的形式输出 fileName=kw+'.html'#存储为网页形式 with open(fileName,'w+',encoding='utf-8') as fp: fp.write(page_text)#写入fp print(fileName,"保存成功!!")

以上是“Python Requests爬虫中如何求取关键词页面”这篇文章的所有内容,感谢各位的阅读!相信大家都有了一定的了解,希望分享的内容对大家有所帮助,如果还想学习更多知识,欢迎关注编程网Python频道!

--结束END--

本文标题: Python Requests爬虫中如何求取关键词页面

本文链接: https://www.lsjlt.com/news/322694.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0