目录 前言1 题目介绍2 数据清洗3 数据可视化分析4 模型训练5 源码 前言 这是我在大三选修课的课程设计,内容参考了Kaggle上高赞的代码,有详细批注,整体比较基础,结构相对完整,便于初学者学习。这个是一个分类问题,我的

这是我在大三选修课的课程设计,内容参考了Kaggle上高赞的代码,有详细批注,整体比较基础,结构相对完整,便于初学者学习。这个是一个分类问题,我的另外一篇博客《Kaggle回归问题Mercedes——Benz Greener Manufacturing》介绍了回归问题。除此之外我的《电商评论文本挖掘》也是我当年的课程设计,也有详细的批注,相比这个难度会稍微高些。

题目背景:在1912年4月15日,当时世界最豪华的游艇,泰坦尼克号撞到冰山沉入海底,其中船上2224位乘客中的1502位死在了此次事故中。在幸存者中,尽管有一些是来自于幸运,但是大部分幸存着是来自于女人、小孩还有一些贵族。而我们的任务就是通过机器学习,计算出人们幸存的概率。

数据介绍:

| 变量 | 含义 | 备注 |

|---|---|---|

| survival | 存活情况 | 0为没有存活;1位存活 |

| pclass | 船舱地址 | 1为最好;2为中等;3为最差 |

| sex | 性别 | |

| age | 年龄 | |

| sibsp | 同行的配偶或兄妹数量 | |

| parch | 同行的父母或孩子数量 | |

| ticket | 票号 | |

| fare | 船票价格 | |

| cabin | 船仓号 | |

| embarked | 登船港口 | C为Cherbourg;Q为Queen Stown;S为Southampton |

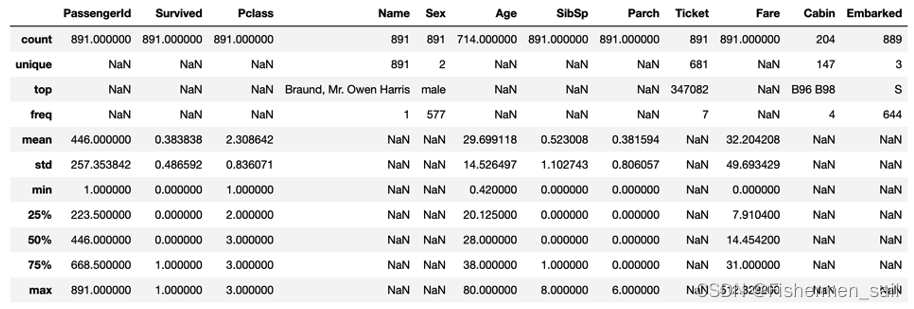

1)首先对所有数据进行整体概览。

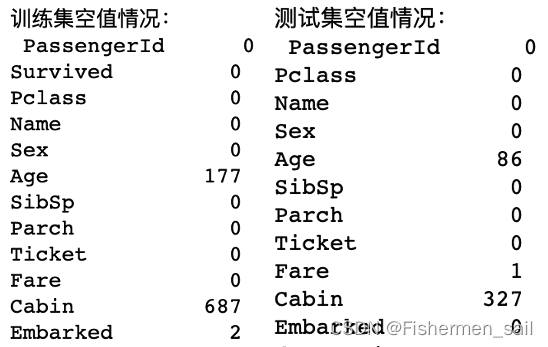

2)观察空值情况,发现需要处理Age与Cabin。

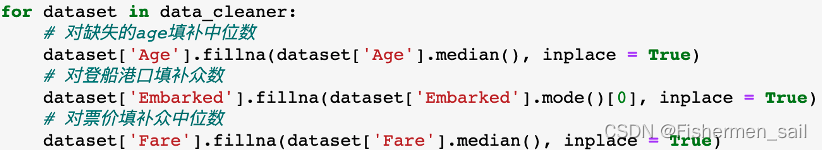

3)填补缺失值,对Age使用中位数填补,对Cabin船舱号使用众数填补,对Fare使用中位数填补。

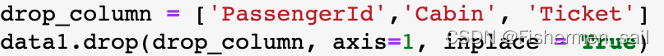

4)由于乘客ID是从1按顺序增加,与其他变量没有相关性;船舱有太多缺失;票号有纯数字,有字母加数字,而且全是不同的,无法使用。对这三列进行删除。

5)对数据列进行进一步出列,将SibSp陪同的配偶、兄妹数量和Parch陪同的父母孩子数量混合,合并为FamilySize家庭人数;根据FamilySize可以进一步划分出IsAlone是否独自一人乘船(1为独自,0为非独自);因为英语中一个人的称谓能反应出一些人的年龄、性别或者地位,所以单独将对人名的称谓划分出来;根据票价的大小进行等频率切割,以便之后处理;根据年龄的大小进行按值切割,以便后续处理。

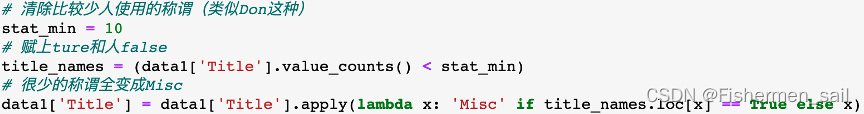

6)根据观察,发现有一些特别、无实际意义的称谓,对他们进行统一处理,变为Misc。

7)对数据中的str类变量,利用LabelEncoder,对标签进行编码,转为数字。

8)经过上面的处理完成了对数据的清洗,下图为原始,与分箱操作的变量名。

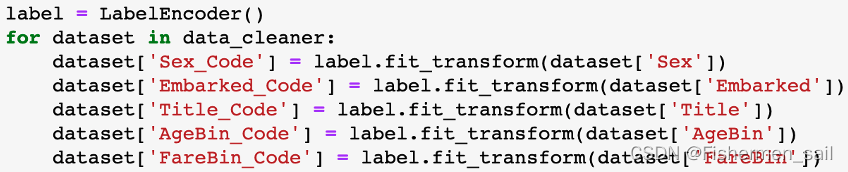

1)对Fare、Age、FamilySize绘制boxplot,可以观察到,票价花费大部分集中在两位数,购买头等舱的并不是很多;年龄大部分集中在28左右,有少部分的婴儿和老人,家庭成员数量普遍为1到2个,也有很多人是独自乘船。

2)利用hist绘制票价花费、年龄分布、家庭成员数量的存活数,可以发现票价越低,死亡人数相对越多;年龄越高或者越低存活概率越高;家庭成员数量在2到5个的存活概率越高。

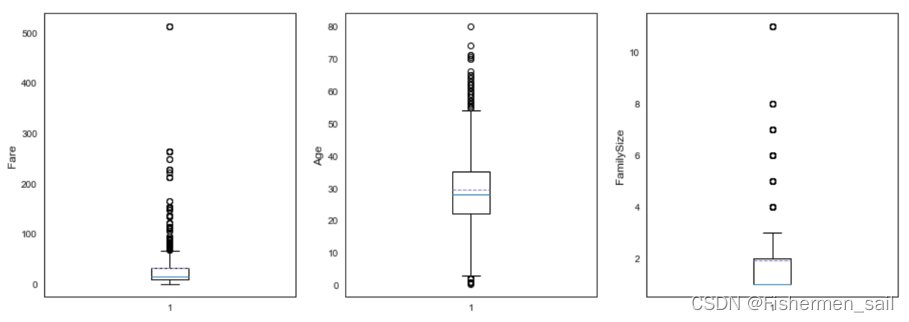

3)利用barplot绘制港口、船舱等级、是否独自一人的幸存率,可以发现,C港口登船的相对存活率最大,头等舱的存活率更大,有同行的人的存活率更大。

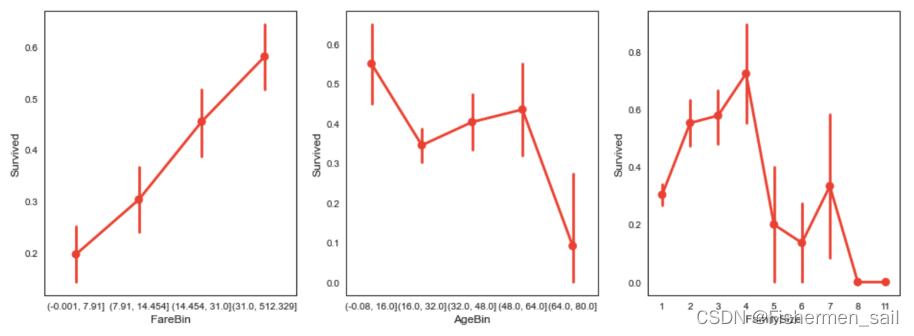

4)利用pointplot绘制票价等级、年龄分布、家庭人数的幸存率,可以发现票价越高存活率越大,16岁以下的孩子与48到64岁间的人存活率更大,家庭成员数量为4的存活率最大。

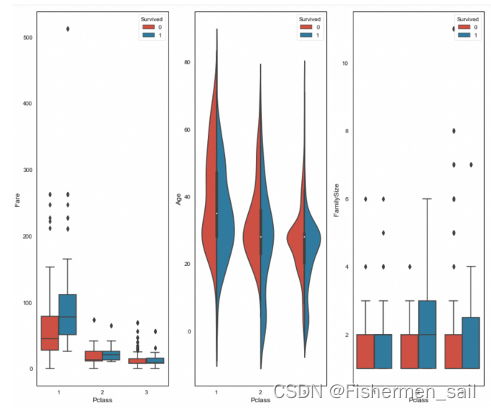

5)利用boxplot與violinplot绘制船舱等级与票价花费、与是否幸存,船舱等级与年龄分布、与是否幸存,船舱等级与年龄分布、与是否幸存,可以发现进一步的关系。

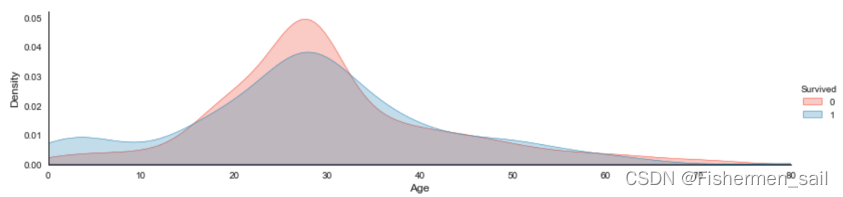

6)利用kdeplot绘制年龄与幸存的核密度图,可以发现婴儿比起老人存活的概率更大,没有幸存下来的主要在30岁左右。

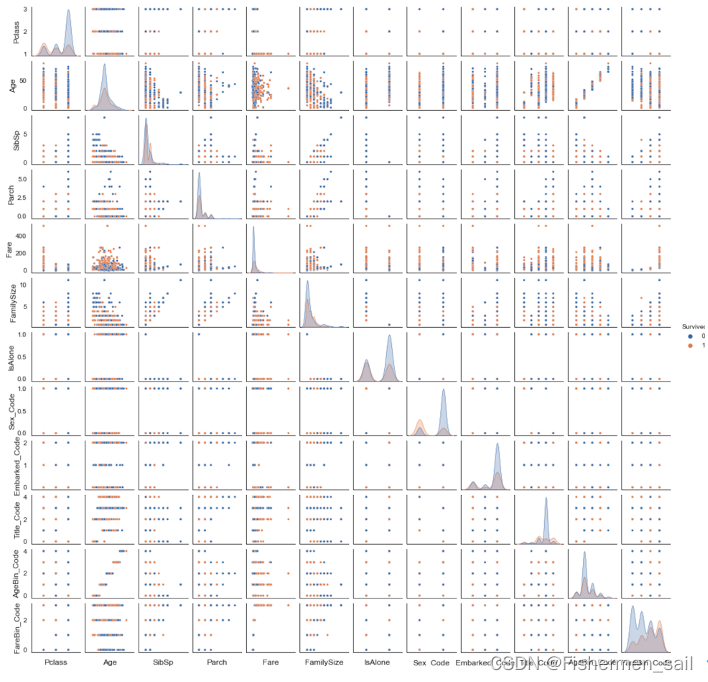

7)利用pairplot,绘制各个属性的关系图,对角线上是各个属性的核密度图,而非对角线上是两个不同属性之间的相关图。

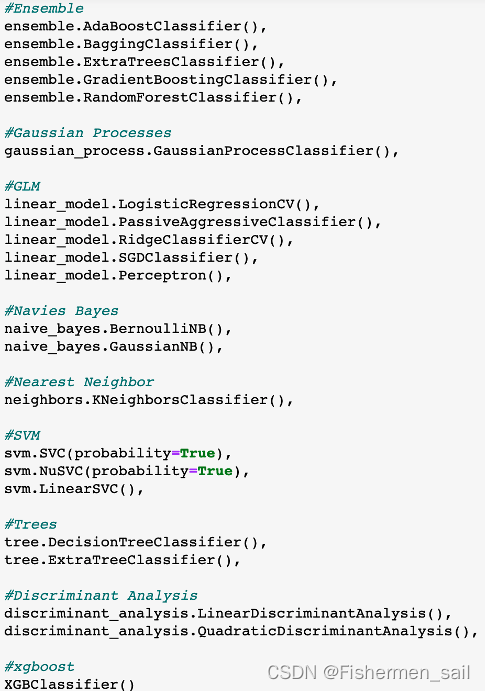

根据如下常用算法模型,进行一一对比选择。

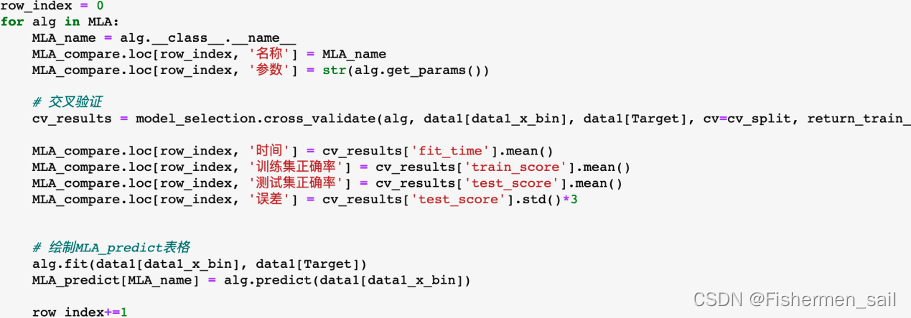

根据ShuffeSplit进行交叉验证数据分割,之后根据cross_validate分别计算出训练集正确率、测试集正确率、标准差。

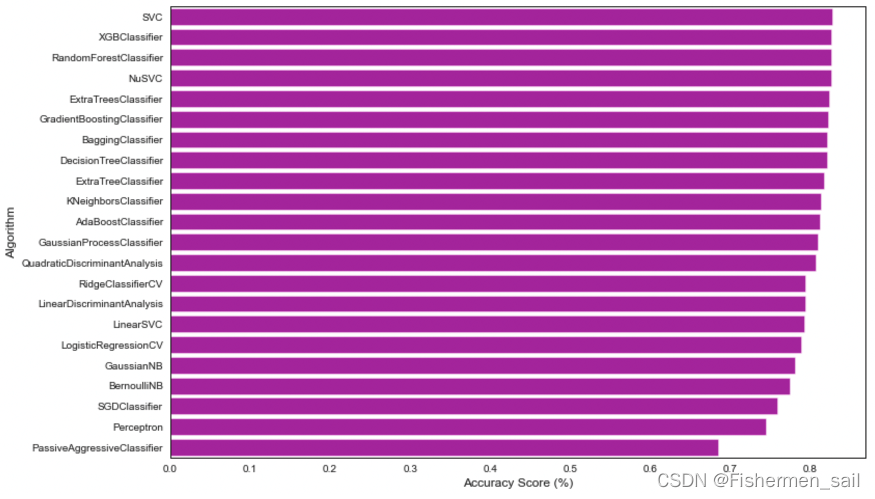

根据训练集正确率对结果进行排序,可以看到SVC的效果最好。

对正确率进行可视化。

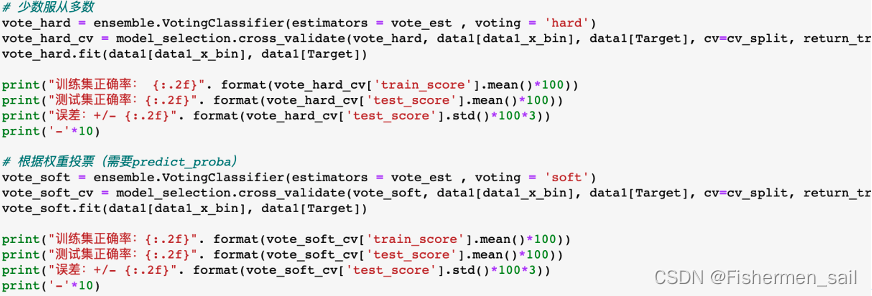

之后也可以利用VotinGClassifier进一步根据多模型“投票”来获得结果,VotingClassifier分为软投票与硬投票,硬投票是指直接根据少数服从多数,软投票是指根据权重进行投票,需要用到predict_proda。根据结果,发现利用软投票效果也还不错,不过时间的代价也比较巨大。

为了更好的观看效果,我将源码放在了Github上,如有帮助,希望点个星星支持一下,感谢。

来源地址:https://blog.csdn.net/Fishermen_sail/article/details/132463948

--结束END--

本文标题: Kaggle分类问题Titanic——Machine Learning from Disaster

本文链接: https://www.lsjlt.com/news/383239.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0