这篇文章给大家分享的是有关node.js怎么爬取中关村的在线电瓶车信息的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。步骤第一步,引入需要的库var cheerio&nb

这篇文章给大家分享的是有关node.js怎么爬取中关村的在线电瓶车信息的内容。小编觉得挺实用的,因此分享给大家做个参考,一起跟随小编过来看看吧。

步骤

第一步,引入需要的库

var cheerio = require('cheerio');

var fetch = require('node-fetch');

// cheerio 是一个类似浏览器端的Jquery,用来解析html的

// fetch 用来发送请求第二步,设置初始的爬取的入口(我身处杭州,所以地区选了杭州的?)

// 初始url

var url = "Http://detail.zol.com.cn/convenienttravel/hangzhou/#list_merchant_loc"

// 由于每个a标签下是相对路径,故需要一个根地址来拼接,如下

var urlRoot = "http://detail.zol.com.cn"

// 存放所有url,之所以用set,是为了防止有相同的而重复爬去

var urls = new Set()

// 存储所有数据

var data = []至此,我们的准备部分结束了?,接下来,开始表演了

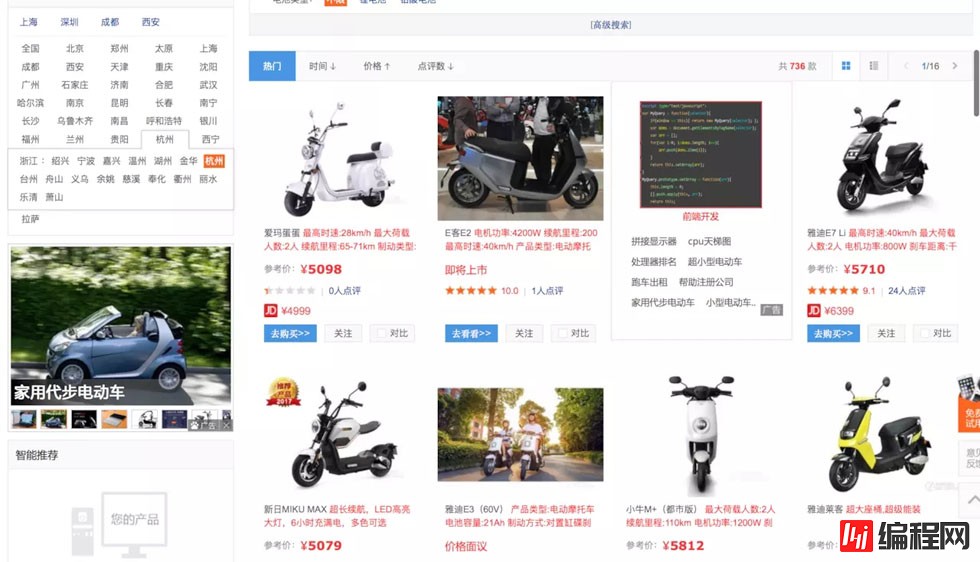

分析网页,思考爬取的方式

每行4款,每页是48款,一共16页

思路:

每次获取当前页48个链接,并点进去之后,拿到该电瓶车的名称和价格(其他信息获取方式一样,自行改就好?)

第一页的全部完成之后,翻到下一页,继续爬,直到最后一页结束

首先我们定义一个函数如下

// 这是得到每个页面的48个链接,并开始发送请求

function ad(arg){

// 参数 arg 先不管

// 本地化一下需要爬取的链接

let url2 = arg || url;

// 请求第一页该网页,拿到数据之后,复制给 app

var app = await fetch(url2).then(res=>res.text())

// 然后假装用jQuery解析了

var $ = cheerio.load(app)

// 获取当前页所有电瓶车的a标签

var ele = $("#J_PicMode a.pic")

// 存放已经爬取过的url,防止重复爬取

var old_urls = []

var urlapp = []

//拿到所有a标签地址之后,存在数组里面,等会儿要开始爬的

for (let i = 0; i < ele.length; i++) {

old_urls.push(fetch(urlRoot+$(ele[i]).attr('href')).then(res=>res.text()))

}

// 用把URL一块丢给promise处理

urlapp = await Promise.all(old_urls)

// 处理完成之后,循环加入jQuery?

for (let i = 0; i < urlapp.length; i++) {

let $2 = cheerio.load(urlapp[i],{decodeEntities: false})

data.push({

name:$2(".product-model__name").text(),

price:$2(".price-type").text()

})

}

// 至此,一页的数据就爬完了

// console.log(data);

// 然后开始爬取下一页

var nextURL = $(".next").attr('href')

// 判断当前页是不是最后一页

if (nextURL){

let next = await fetch(urlRoot+nextURL).then(res=>res.text())

// 获取下一页的标签,拿到地址,走你

ad(urlRoot+nextURL)

}

return data

}

ad()完整代码如下

var cheerio = require('cheerio');

var fetch = require('node-fetch');

var url = "http://detail.zol.com.cn/convenienttravel/hangzhou/#list_merchant_loc"

var urlRoot = "http://detail.zol.com.cn"

// var url = "http://localhost:3222/app1"

var urls = new Set()

var data = []

async function ad(arg){

let url2 = arg || url;

var app = await fetch(url2).then(res=>res.text())

var $ = cheerio.load(app)

var ele = $("#J_PicMode a.pic")

var old_urls = []

var urlapp = []

for (let i = 0; i < ele.length; i++) {

old_urls.push(fetch(urlRoot+$(ele[i]).attr('href')).then(res=>res.text()))

}

urlapp = await Promise.all(old_urls)

for (let i = 0; i < urlapp.length; i++) {

let $2 = cheerio.load(urlapp[i],{decodeEntities: false})

data.push({

name:$2(".product-model__name").text(),

price:$2(".price-type").text()

})

}

var nextURL = $(".next").attr('href')

if (nextURL){

let next = await fetch(urlRoot+nextURL).then(res=>res.text())

ad(urlRoot+nextURL)

}

return data

}

ad()感谢各位的阅读!关于“node.js怎么爬取中关村的在线电瓶车信息”这篇文章就分享到这里了,希望以上内容可以对大家有一定的帮助,让大家可以学到更多知识,如果觉得文章不错,可以把它分享出去让更多的人看到吧!

--结束END--

本文标题: node.js怎么爬取中关村的在线电瓶车信息

本文链接: https://www.lsjlt.com/news/68247.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

2022-06-04

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

一口价域名售卖能注册吗?域名是网站的标识,简短且易于记忆,为在线用户提供了访问我们网站的简单路径。一口价是在域名交易中一种常见的模式,而这种通常是针对已经被注册的域名转售给其他人的一种方式。

一口价域名买卖的过程通常包括以下几个步骤:

1.寻找:买家需要在域名售卖平台上找到心仪的一口价域名。平台通常会为每个可售的域名提供详细的描述,包括价格、年龄、流

443px" 443px) https://www.west.cn/docs/wp-content/uploads/2024/04/SEO图片294.jpg https://www.west.cn/docs/wp-content/uploads/2024/04/SEO图片294-768x413.jpg 域名售卖 域名一口价售卖 游戏音频 赋值/切片 框架优势 评估指南 项目规模

0