Python 官方文档:入门教程 => 点击学习

小编给大家分享一下python爬虫基础之selenium库怎么用,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!一、selenium简介官网总的来说: seleni

小编给大家分享一下python爬虫基础之selenium库怎么用,相信大部分人都还不怎么了解,因此分享这篇文章给大家参考一下,希望大家阅读完这篇文章后大有收获,下面让我们一起去了解一下吧!

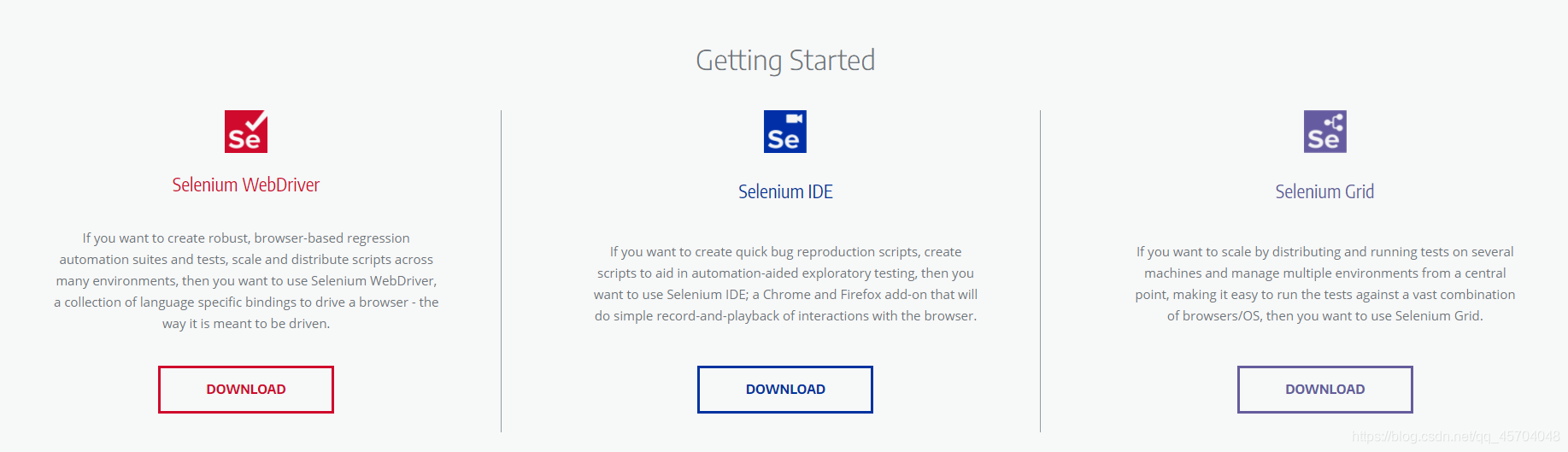

官网

总的来说: selenium库主要用来做浏览器的自动化脚本库。

from selenium import WEBdriverurl = 'Http://www.baidu.com'# 将webdriver实例化path = 'C:\Program Files (x86)\python38-32\chromedriver.exe'browser = webdriver.Chrome(executable_path = path)# 用谷歌浏览器访问百度 r = browser.get(url)with open ('test.txt','wb+') as f: f.write(r.content)'''代码功能:selenium是的常用用法时间:@Date: 2021-05-22 21:37:05'''from selenium import webdriver# 导入Options类from selenium.webdriver.chrome.options import Optionsurl = "https://movie.douban.com/"# Options的实例化chrome_options = Options()# 设置浏览器参数# --headless 是不显示浏览器启动以及执行过程chrome_options.add_argument('--headless')# 设置lang和User-Agent信息,防止反爬检测chrome_options.add_argument('lang=zh_CN.utf-8')UserAgent = 'Mozilla/5.0 (windows NT 10.0; WOW64) AppleWebKit/537.36 (Khtml, like Gecko) Chrome/90.0.4430.93 Safari/537.36'chrome_options.add_argument('User-Agent='+UserAgent)# 启动浏览器并设置chrome_options参数driver = webdriver.Chrome(chrome_options=chrome_options)# 设置浏览器窗口最大化# driver.maximize_window()# # 设置浏览器窗口最小化# driver.minimize_window()driver.get(url)# 获取网页的标题print(driver.title)# page_source是获取网页的HTML代码print(driver.page_source)from selenium import webdriverimport time# 启动浏览器driver = webdriver.Chrome()driver.get('https://www.youdao.com')time.sleep(5)# 添加cookiedriver.add_cookie({'name':'login','value':'登录'})# 获取全部cookieallCookies = driver.get_cookies()print('全部cookies',allCookies)# 获取name为login的cookiecookie = driver.get_cookie('login')print('name为login的cookie',cookie)# 删除单个cookiedriver.delete_cookie('login')print("\n--------------剩余的cookies\n",driver.get_cookies())# 删除全部cookiesdriver.delete_all_cookies()print("-------------剩余的cookies------------\n",driver.get_cookies())time.sleep(60)<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8"> <meta http-equiv="X-UA-Compatible" content="IE=edge"> <meta name="viewport" content="width=device-width, initial-scale=1.0"> <title>Document</title></head><body> <h2>配合selenium模拟上传文件</h2> <input type='file' name='file' /></body></html>'''代码功能:selenium上传文件 --配合upload.html使用时间:@Date: 2021-05-23 09:56:53'''from selenium import webdriverimport timedriver = webdriver.Chrome()url = 'http://localhost:52330/selenium/upload.html'driver.get(url)ele = driver.find_element_by_name('file')print("获取到的元素",ele)# 注意路径不能有中文字符ele.send_keys('D:\dcsdk_eventv3.db')time.sleep(10)下载文件

'''代码功能:模拟文件下载时间:@Date: 2021-05-23 10:21:28'''from selenium import webdriverimport time# 设置文件保存路径,如果不设置,会默认保存到Downloads文件夹options = webdriver.ChromeOptions()prefs = {'download.default_directory':'D:\\'}options.add_experimental_option('prefs',prefs)# 启动浏览器driver = webdriver.Chrome()# 下载PC版微信driver.get('https://pc.weixin.qq.com')# 浏览器窗口最大化driver.maximize_window()time.sleep(5)# 点击下载按钮driver.find_element_by_class_name('download-button').click()time.sleep(30)from selenium import webdriverimport timeurl = 'https://www.baidu.com/'driver = webdriver.Chrome()# 隐式等待,一次设置对整个driver的周期都起作用driver.implicitly_wait(30)driver.get(url)# 使用js开启新的窗口js = 'window.open("https://www.soGou.com/")'driver.execute_script(js)# 获取当前显示的窗口信息current_window = driver.current_window_handleprint(driver)# 获取浏览器的全部窗口信息handles = driver.window_handlesprint('获取到的窗口全部信息\n------------------\n',handles)'''获取到的窗口全部信息------------------ ['CDwindow-7FB808B4F24EF5385A9AFBDC21FA13B9', 'CDwindow-E879C0A64E734C3F88468A4388F48E3B']'''# 设置延时看切换的效果time.sleep(3)# 根据窗口信息进行窗口切换# 切换到百度搜索的窗口driver.switch_to_window(handles[0])time.sleep(3)# 切换到搜狗窗口driver.switch_to_window(handles[1])'''代码功能:熟悉selenium的自动化操作时间:2020/5/22'''from selenium import webdriverfrom selenium.webdriver.common.keys import Keysimport time# Keys 类中定义了很多快捷键url = 'https://wwww.baidu.com'path = 'C:\Program Files (x86)\python38-32\chromedriver.exe'driver = webdriver.Chrome(executable_path=path)driver.get(url)# 获取输入框标签对象element = driver.find_element_by_id('kw')# 输入框输入内容element.send_keys('Python你')time.sleep(2)# 删除最后一个文字element.send_keys(Keys.BACK_SPACE)time.sleep(2)# 添加空格加教程element.send_keys(Keys.SPACE)element.send_keys("教程")time.sleep(2)# ctrl+a 全选输入框内容element.send_keys(Keys.CONTROL, 'a')time.sleep(2)# ctrl+x 剪切输入框内容element.send_keys(Keys.CONTROL, 'x')time.sleep(2)# ctrl+v 复制element.send_keys(Keys.CONTROL, 'v')time.sleep(2)# 回车键driver.find_element_by_id('su').send_keys(Keys.ENTER)time.sleep(10)1、简单易用,与C/C++、Java、C# 等传统语言相比,Python对代码格式的要求没有那么严格;2、Python属于开源的,所有人都可以看到源代码,并且可以被移植在许多平台上使用;3、Python面向对象,能够支持面向过程编程,也支持面向对象编程;4、Python是一种解释性语言,Python写的程序不需要编译成二进制代码,可以直接从源代码运行程序;5、Python功能强大,拥有的模块众多,基本能够实现所有的常见功能。

以上是“Python爬虫基础之selenium库怎么用”这篇文章的所有内容,感谢各位的阅读!相信大家都有了一定的了解,希望分享的内容对大家有所帮助,如果还想学习更多知识,欢迎关注编程网Python频道!

--结束END--

本文标题: Python爬虫基础之selenium库怎么用

本文链接: https://www.lsjlt.com/news/277766.html(转载时请注明来源链接)

有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

下载Word文档到电脑,方便收藏和打印~

2024-03-01

2024-03-01

2024-03-01

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

2024-02-29

回答

回答

回答

回答

回答

回答

回答

回答

回答

回答

0